错误的数据集正在翘曲我们的良好AI的感觉

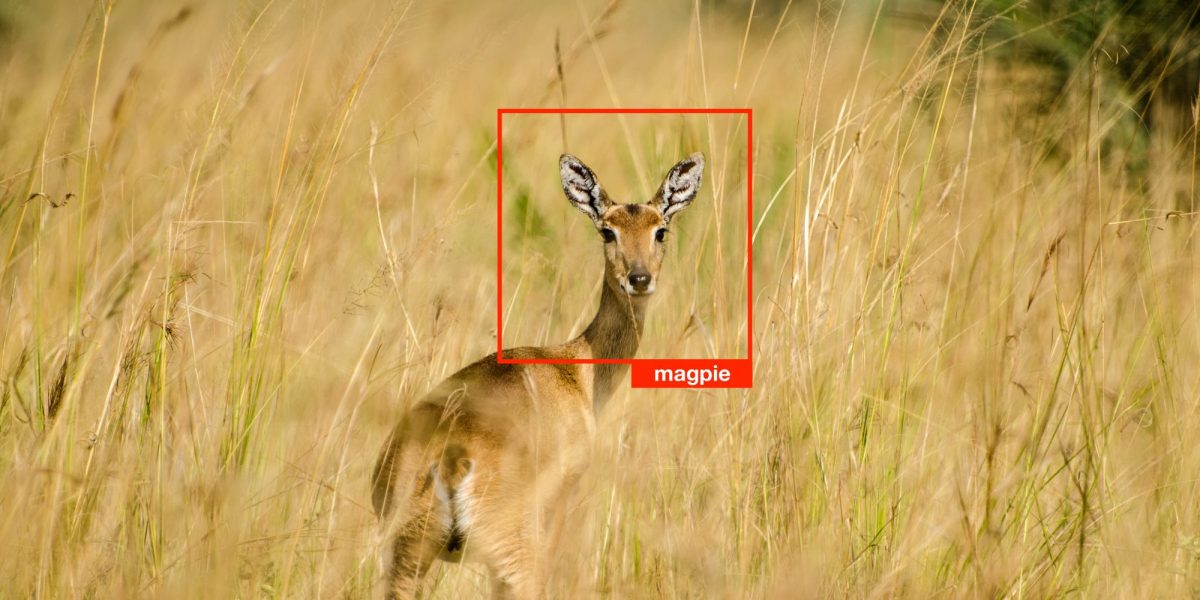

是的,但是:近年来,研究发现这些数据集可以包含严重的缺陷。例如,想象力,包含种族主义和性别歧视标签以及未经同意获得的人面孔的照片。最新的研究现在看出另一个问题:许多标签只是错误的错误。蘑菇被标记为勺子,一只青蛙标记了一只猫,Ariana Grande的高音是哨子。 ImageNet测试集的估计标签错误率为5.8%。同时,用于QuickDraw的测试集,手绘汇编,估计误差率为10.1%。

它是如何测量的?用于评估模型的10个数据集中的每一个都具有用于训练它们的相应数据集。研究人员,麻省理工学院研究生柯蒂斯G. Northcutt和Anish Athalye和Alum Jonas Mueller,使用训练数据集开发机器学习模型,然后用它来预测测试数据中的标签。如果模型不同意原始标签,则数据点被标记为手动审核。亚马逊机械土耳其人的五名人类评论者被要求投票表决 - 模型或原始的 - 他们认为是正确的。如果大多数人类评论者同意该模型,原始标签被误差,然后纠正。

这件事吗?是的。研究人员展望了34种型号,其性能先前已经针对想象网测试集测量。然后,他们对每个模型进行了针对每个模型,其中大约1,500个例子,其中发现数据标签错误。他们发现,在原始错误标签上没有表现得很好的模型是标签纠正后的一些最佳表演者。特别是,更简单的模型似乎在纠正的数据上衡量比谷歌这样的科技巨头用于图像识别的更复杂的模型,并且假定是该领域最好的。换句话说,我们可能有一个夸大的这些复杂模型是因为有缺陷的测试数据。

怎么办? Northcutt鼓励AI字段为评估模型和跟踪该字段的进度来创建清洁数据集。他还建议研究人员在处理自己的数据时改善他们的数据卫生。否则,他说,“如果你有一个嘈杂的数据集和一堆你正在尝试的模型,你将在现实世界中部署它们,”你最终可以选择错误的模型。为此,他开辟了他在纠正标签错误的研究中使用的代码,他说已经在一些主要的科技公司中使用。