“生物学上可信”的深度学习神经元预测巴赫的和弦

今天,正如“自然·机器智能”(Nature Machine Intelligence)所报道的那样,我和我的同事们展示了一种深度学习的新方法,这种方法结合了生物启发的神经动力学,并实现了记忆中的加速,使其更接近人脑的工作方式。研究结果表明,人工智能(AI)中的应用程序将广泛采用更具生物真实性的深度学习。

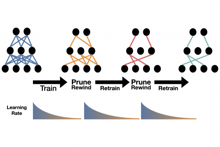

放电神经网络(SNNs)具有固有的时间动力学,它依赖于稀疏的全有或全无放电的时间和存储在神经细胞膜电位中的内部状态,反映了真实神经元的工作方式。利用这些动力学被认为是非常有前途的,SNN被认为是继生物逼真程度较低的人工神经网络(ANN)之后的下一代人工智能。尽管为利用SNN动力学的独特能力做出了重大努力,但与深入学习神经网络的惊人进展相比,大多数与SNN相关的研究活动取得的成功有限。

在IBM欧洲研究院,我们研究SNN和ANN已经有十多年了,有一天我们突然想到:“我们能把尖峰神经元和ANN的神经动力学特征结合起来吗?”

答案是肯定的,我们可以。更具体地说,我们使用由两个递归连接的人工神经元组成的结构来建模尖峰神经元-我们称之为尖峰神经元单元(SNU)。

SNU在SNN与ANN世界之间架起了桥梁。从实践的角度来看,SNU使深度学习进步能够直接应用于开发和训练具有随时间反向传播的复杂SNN。它实现了架构、框架、训练算法和基础设施的重用。从理论的角度来看,SNN独特的生物现实动力学可以为深度学习社区所用。SNU可以在尖峰模式或非尖峰软模式下操作。在这两种情况下,它的动力学性能都不同于递归神经网络、基于LSTM或GRU的网络,并且在现有的ANN模型中需要最少的单位参数来处理时间数据。

此外,SNU有助于在人工神经网络加速器中高效实现,特别适合使用内存计算的应用程序。内存计算技术是人工智能硬件的一种很有前途的新方法,它从大脑的架构中获得灵感,在大脑的架构中,记忆和计算在神经元中结合。内存计算通过在内存中执行计算,避免了在单独的内存和处理器之间来回洗牌数据的能源成本-相变内存技术是这种实现的一个很有希望的候选者,这一点众所周知,并将在未来几年走向商业化。我们的工作包括对内存中SNU实现的实验演示,该实现对硬件缺陷的鲁棒性优于其他最先进的人工神经网络单元。

为了展示SNU在解决实际任务中的能力,我们使用MNIST数据集将其应用于手写数字识别,使用宾夕法尼亚树库数据集进行语言建模,并使用约翰·塞巴斯蒂安·巴赫合唱团数据集进行复调音乐预测。在执行完每一项任务后,我们的方法在SNN上获得了最先进的性能,并且在软模式下,性能超过了使用ANN的类似体系结构的性能。

对于手写数字识别,我们使用了数据集的一个具有挑战性的尖峰变体。我们首先评估了深度对基于全连接SNU的SNN的影响。随着网络深度的增加,准确率不断提高,最终在7层SNN上达到98.47%的平均识别率,在4层网络中使用sSNUs的平均识别率为98.5%。为了进一步提高识别精度,并说明SNU概念如何直接受益于深度学习的进步,我们在标准卷积结构中用SINS取代了人工神经元,保持了所有其他设置和超参数不变。在100个历元之后,我们获得了使用标准数据集进行训练的平均准确率为99.21%,使用经过弹性失真预处理的输入进行训练的平均准确率为99.53%-超过了各种最先进的SNN实现。

语言建模任务涉及基于先前观察到的单词序列的上下文预测下一个单词。例如,给出句子的任何部分,“伦敦市场美元存款的报价利率”,我们的系统几乎完全能够正确预测连续的单词。在看到“美国的美元存款利率”后,它犯了一个有趣的错误,预测的是“美国”而不是“伦敦”。同时,这表明它正确地把握了意思,预计下一个词是一个地点,甚至在前面提到的“美元”的基础上提出了“美国”。

该结构的前馈测试复杂度达到137.7,优于传统的自然语言处理方法,如“5-gram”方法。据我们所知,这是在Penn Treebank数据集上使用SNN执行的第一个语言建模示例,我们的结果设置了SNN最先进的性能。应用具有循环连接的sSNN将结果提高到108.4,这超过了相应的无丢弃的基于LSTM的体系结构。

在约翰·塞巴斯蒂安·巴赫的数据集上进行复调音乐预测的任务是在每个时间步长预测要在连续时间步长中演奏的一组音符,即和弦。我们使用了一种基于SNU的架构,其输出层为乙状神经元层,允许将获得的损失值与神经网络的损失值进行直接比较。基于SNU的网络实现了8.72的平均损耗,并为巴赫合唱团数据集设定了SNN最先进的性能。基于sSNU的网络进一步将平均损耗降低到8.39,并超过了使用最先进的人工神经网络单元的相应体系结构。

长期以来,SNN和ANN对算法和人工智能硬件加速器体系结构的研究一直是分开进行的,但在本文中,我们提出了一种SNU,它以一种新颖的ANN单元的形式结合了生物启发的神经动力学,为挑战应用提供了广泛的生物启发神经动力学,并为神经形态硬件加速开辟了新的途径。

自然机器智能,融合了生物启发的神经动力学和内存计算的深度学习,例如Stanisław WoźNiak,Angeliki Pantazi,Thomas Bohnstingl和Evangelos Eleftheriou,

与受新冠肺炎疫情影响的许多其他事件一样,ACM SIGMOD/PODS 2020将于6月14日至6月19日期间举行。SIGMOD 2020的工作重点从将图形查询添加到关系数据库,到将自然语言接口添加到数据,再到为新的人工智能工作负载操作数据。将要展示的结果包括我们的IBM Research-Almaden和IBM Research-India实验室所做的工作,以及我们来自大学的暑期实习生和我们在IBM其他部门的合作伙伴所做的工作。

就像许多影响新冠肺炎大流行的事件一样,计算机视觉与模式识别年度会议(CVPR2020)已经虚拟化。对于我们所有人来说,这是一个有趣的时刻,因为我们找到了新的工作方式和机会,可以应用我们的研究来帮助我们的社区。

在过去的十年中,自然语言处理(NLP)领域取得了长足的进步。事实上,NLP在当今的人工智能应用中非常常见,无论消费者是在与虚拟助手交流,询问旅行方向还是搜索天气预报,他们都有可能与某种形式的NLP互动。然而,这项技术[…]