Google的说话口水声凝视跟踪AI帮助有障碍的用户交流

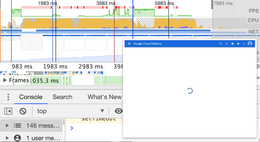

谷歌今天发布了一款针对Android的实验性应用,该应用利用AI使有言语和运动障碍的人们可以更轻松地进行交流。它被称为“说话说话”,它跟踪眼睛的运动,使人们可以用眼睛选择预先编写的,可自定义的短语并大声说出来。

在美国,大约有1850万人的语音,语音或语言障碍。眼睛注视跟踪设备可以提供一定的独立性,但是它们通常不便于携带,而且价格昂贵。例如,入门级的Tobii 4C眼动仪起价为150美元。

为了满足这一需求,语音和语言治疗师Richard Cave开始与Google的一个小组合作,开发了Look to Speak。该应用程序是免费提供的,并且与Android 9.0及更高版本兼容,使用户可以向左,向右或向上浏览,以从短语列表中选择要说的内容。

借助“说话说话”,人们可以个性化列表中的单词和句子并调整视线敏感度设置。 Google表示,该应用程序的数据保持私有状态,永远不会离开安装该应用程序的手机。

“说说话”是Google的“与Google进行实验”的“从一个开始”计划的一部分,该计划是由Google工程师和其他开发人员创建的AI项目和实验平台。但是该公司在AI方面的可访问性工作超出了一个生态系统。

10月初,Google宣布将Google Assistant引入Tobii Dynavox的应用程序和服务,使具有辅助功能的用户可以将虚拟磁贴分配给控制智能家居设备和电器的操作。两家公司还合作将Action Blocks和UI元素集成在一起,以使智障人士更容易使用Google Assistant,以及Tobii的数千种基于图片的符号来进行呼叫,发送文本,播放视频等。

去年11月,Google推出了Project Guideline,该项目使用AI帮助弱视用户导航正在运行的课程。 Google还将继续开发Lookout,这是一个以可访问性为重点的应用程序,可以使用计算机视觉识别包装食品,扫描文档以更轻松地查看信件和邮件等等。还有Euphonia项目,旨在帮助语音障碍者更轻松地交流; Live Relay,它使用设备上的语音识别和文本转语音功能,使电话代表一个人听和说;和Project Diva,它可以帮助人们在不使用语音的情况下发出Google Assistant命令。