NVIDIA首席执行官推出NVIDIA安培架构、NVIDIA A100图形处理器

NVIDIA今天提出了下一代计算的愿景,将全球信息经济的重点从服务器转移到新一类强大、灵活的数据中心。

NVIDIA创始人兼首席执行官Jensen Huang在他加州家中的厨房录制的6集同时发布的主旨演讲中,讨论了NVIDIA最近收购Mellanox、基于该公司期待已久的NVIDIA Ampere GPU架构的新产品以及重要的新软件技术。

原计划于3月下旬在圣何塞举行的NVIDIA图形处理器技术大会上现场发表主旨演讲的计划被冠状病毒大流行打乱了。

“我要感谢所有奋战在一线抗击冠状病毒的勇敢男男女女,”黄说。

黄解释说,NVIDIA正在与研究人员和科学家合作,使用GPU和人工智能计算来治疗、缓解、控制和跟踪这种流行病。在提到的人中:

橡树岭国家实验室和斯克里普斯研究所在一天内筛选了10亿种潜在的药物组合。

Structura生物技术公司、德克萨斯大学奥斯汀分校和美国国立卫生研究院已经重建了病毒刺突蛋白的3D结构。

NVIDIA还宣布更新其NVIDIA Clara医疗平台,旨在对抗冠状病毒。

黄说:“应用NVIDIA加速计算来拯救生命的研究人员和科学家是我们公司宗旨的完美例子-我们制造计算机是为了解决普通计算机无法解决的问题。”

黄演讲的核心是关于数据中心-现代全球信息经济的引擎室-正在发生怎样的变化,以及在上个月完成的一笔交易中收购的NVIDIA和Mellonox是如何共同推动这些变化的。

“数据中心是新的计算单元,”黄说,并补充说,NVIDIA正在加速从芯片到CPU和GPU连接方式,到整个软件堆栈,最终跨整个数据中心的性能提升。

这始于一种新的GPU架构,该架构针对这种新的数据中心规模的计算进行了优化,统一了AI培训和推理,并使灵活、弹性的加速成为可能。

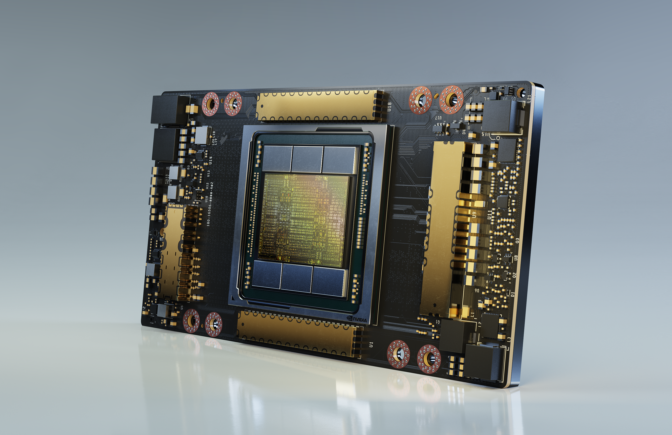

黄宣布,NVIDIA A100是第一款基于NVIDIA安培架构的GPU,提供了NVIDIA八代GPU中最大的世代性能飞跃,也是为数据分析、科学计算和云图形而打造的,目前正在全面生产并向全球客户发货。

18家世界领先的服务提供商和系统建造商正在整合它们,其中包括阿里巴巴云、亚马逊网络服务、百度云、思科、戴尔技术、谷歌云、惠普企业、微软Azure和甲骨文。

黄说,A100和它所基于的NVIDIA Ampere架构,比它的前身提高了高达20倍的性能。他详细介绍了A100的五个关键功能,包括:

第三代张量以TF32为核心,这是一种新的数学格式,可以加速开箱即用的单精度AI训练。黄解释说,NVIDIA广泛使用的张量芯现在更灵活、更快、更容易使用。

结构稀疏加速,一种新的效率技术,利用AI数学的固有稀疏性来获得更高的性能。

多实例GPU或MIG,允许将单个A100分区为多达七个独立的GPU,每个GPU都有自己的资源。

第三代NVLink技术,将GPU之间的高速连接速度提高了一倍,使A100服务器可以充当一个巨型GPU。

所有这一切的结果是:训练性能比NVIDIA的上一代Volta架构高6倍,推理性能高7倍。

NVIDIA还将出货其基于NVIDIA A100的第三代NVIDIA DGX AI系统-NVIDIA DGX A100-世界上第一台5petaflops服务器。每个DGX A100可以划分为多达56个应用程序,所有应用程序都独立运行。

黄说,这允许单台服务器要么“向上扩展”,以完成人工智能训练等计算密集型任务,要么“向外扩展”,进行人工智能部署或推理。

该系统的首批接受者包括美国能源部的阿贡国家实验室(Argonne National Laboratory),该实验室将利用集群的人工智能和计算能力更好地了解和对抗冠状病毒;佛罗里达大学;以及德国人工智能研究中心。

黄解释说,一个数据中心由5个用于人工智能训练和推理的DGX A100系统供电,仅需28千瓦的电力,成本为100万美元,就可以完成一个典型的数据中心的工作,其中有50个用于人工智能训练的DGX-1系统和600个CPU系统,消耗630千瓦,成本超过1100万美元。

“你买的越多,你存的钱就越多,”黄在他常见的主旨重复中说。

还需要更多吗?黄还宣布了下一代DGX超级吊舱。黄说,它由140个DGX A100系统和Mellanox网络技术驱动,提供700千万亿次人工智能性能,相当于世界上最快的20台计算机之一。

NVIDIA正在扩大自己的数据中心,推出4个DGX超级吊舱,为其SATURNV内部超级计算机增加2.8exaflops的AI计算能力-总容量为4.6exaflops,使其成为世界上速度最快的AI超级计算机。

黄还发布了NVIDIA EGX A100,将强大的实时云计算能力带到了边缘。其NVIDIA安培架构图形处理器提供第三代张量内核和新的安全功能。由于其NVIDIA Mellanox ConnectX-6 SmartNIC,它还包括安全、闪电般的联网功能。

黄还宣布,NVIDIA GPU将为主要软件应用程序提供动力,以加速三个关键用途:管理大数据,创建推荐系统,以及构建实时、对话式人工智能。

随着机器学习的有效性驱使公司收集越来越多的数据,这些新工具应运而生。“这种积极的反馈使我们体验到收集的数据量呈指数级增长,”黄说。

为了帮助所有类型的组织跟上步伐,黄宣布在Spark 3.0上支持NVIDIA GPU加速,将大数据分析引擎描述为“当今世界最重要的应用之一”。

黄说,基于Rapids构建的Spark 3.0打破了提取、转换和加载数据的性能基准。它已经帮助Adobe智能服务实现了90%的计算成本降低。

黄宣布,关键的云分析平台-包括Amazon SageMaker,Azure Machine Learning,Databricks,Google Cloud AI和Google Cloud Dataproc-都将通过NVIDIA加速。

黄说:“我们现在已经为未来做好了准备,届时数据量将继续呈指数级增长,从几十或几百PB增加到艾级甚至更高。”

黄还推出了NVIDIA Merlin,这是一个用于构建下一代推荐系统的端到端框架,正在迅速成为更加个性化的互联网的引擎。黄说,梅林将创建推荐系统所需的时间从100TB的数据集大幅削减到20分钟,从4天减少到20分钟。

他还详细介绍了NVIDIA Jarvis,这是一个新的端到端平台,用于创建实时、多模式对话AI,可以利用NVIDIA AI平台释放的功能。

黄用一段演示突显了它的能力,演示显示他与友好的人工智能Misty互动,Misty理解并实时回应一系列关于天气的复杂问题。

黄还深入挖掘了自2018年NVIDIA RTX在SIGGRAPH上推出以来,NVIDIA在实时光线跟踪方面取得的快速进展,他宣布,NVIDIA Omniverse现在可供早期接入客户同时工作,它允许“在不同地方使用不同工具做同一设计的不同部分的不同设计师”。

自动驾驶汽车是我们这个时代最大的计算挑战之一,黄说,NVIDIA在这个领域继续推进NVIDIA的驱动。

NVIDIA Drive将使用配备嵌入式NVIDIA Ampere GPU的新型Orin SoC,以实现能效和性能,为前挡风玻璃提供5瓦ADAS系统,并可扩展至2,000顶5级机器人出租车系统。

现在,汽车制造商有了单一的计算架构和单一的软件堆栈,可以将人工智能构建到他们的每一辆车中。

“现在汽车制造商可以用一种架构开发整个车队,利用他们整个车队的软件开发,”黄说,“现在汽车制造商可以用一个架构来开发整个车队,利用他们整个车队的软件开发。”

NVIDIA驾驶生态系统现在包括轿车、卡车、一级汽车供应商、下一代移动服务、初创公司、地图服务和模拟。

黄宣布,NVIDIA正在将用于管理整个自动驾驶车队的NVIDIA Drive RC添加到其NVIDIA驱动技术套件中。

NVIDIA还继续推进其NVIDIA Isaac软件定义的机器人平台,宣布宝马已选择NVIDIA Isaac机器人为其下一代工厂提供动力。

黄解释说,宝马在全球的30家工厂每56秒生产一辆汽车:也就是40款不同的车型,每款有数百种不同的选择,由来自世界各地近2000家供应商的3000万个零部件制造。

宝马加入了一个庞大的NVIDIA机器人全球生态系统,该生态系统涵盖送货服务、零售、自动移动机器人、农业、服务、物流、制造和医疗保健。

在未来,工厂实际上将成为巨大的机器人。“里面的所有活动部件都将由人工智能驱动,”黄说。“未来量产的每一款产品都将是定制化的.”