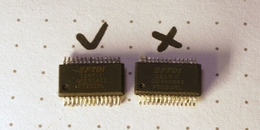

AI芯片公司的细分

我看到我在自动驾驶汽车的AI芯片公司中发生了类似的事情。您有许多疯狂的过度传奇的公司,有0个产品市场的适合,从不介意收入或利润。

这些公司不是一个我可以购买的产品! AI Chips的当前领导人毫无疑问,我可以买一张卡片。所以留下了这个问题,是公司银行在一个愚蠢的商业模式,还是他们没有任何东西?我倾向于认为这是后者。记住:除非是来自苹果这样的轨道记录的公司,秘密只是掩盖“我们没有狗屎”

以下是GraphCore IPU架构的技术报告。它看起来很难努力。虽然他们现在有购买按钮,但它链接到联系我们的表格。如果公司有联系我们的表格门控销售,这意味着他们的产品在自己的研究中实际上并不竞争力,但他们希望销售人员将错误地说服你。

虽然我必须到达第7页的报告来查找问题,但它与细胞SPE相同。他们依靠许多核心芯片,具有自定义奇怪的通信协议。您想尝试保留快速代码吗?游戏devs讨厌spe,为什么不讨厌这个?

他们似乎可以获得正确的想法,或者至少匹配我将与在左右1个GHz的单一大核心相匹配。这是他们的技术报告。我听说他们得到了细节的错误,而且他们仍然对他们的resnet-50绩效(2015年的时代网络)发表讲话。

问题在第一个报告页面上是显而易见的,同样的错误作为鼬,但这种方法对编译器造成了沉重的负担,这必须理解指令流量和数据流的双脉冲,同时优化功能单元利用率。编译器必须计划所有数据移动,管理内存和功能单位,甚至手动获取指令。“这将其推动到静态软件策略从未在计算机架构的历史中工作过。

我将从报告中再次句刑,“内存单位还存储VLIW指令,这些指令是2,304(144x16)字节宽”参考,RISC-V指令是4字节宽。希望您喜欢在16KB的ICACH中拟合7条说明!

他们的芯片被称为Grayskull,几乎没有关于这个拱形发布的信息,我被告知获得演示的唯一方法是签署有希望的东西,不要对它说什么不对。这不会激发更多的(阅读:任何)对它的信心,如果人们是诚实和透明的,那么如果他们不是那么好。但现在吉姆凯勒在那里,也许有希望。

我们制作大芯片!芯片真的很大!大必须是好的,因为很大!大芯片意味着大投资!祝你在任何理智的方式控制400,000个核心。

AI芯片之王。 3090甚至不是一个不好的交易!问题是5X价格过高的A100,而且,一个,一个,他们有垄断和二,筹码仍然主要被设计为与AI作为事后的游戏GPU。虽然432张核心核心有一个疯狂的絮凝物(8x4x4 = 128 fmas),但几乎不可能让他们从内存中喂食,甚至缓存,并且在现实性能中达到10倍。 (这是我们从中获得10倍的速度)

TPU基于Tensorflow。虽然它与Pytorch合作,但它真的意味着以特定方式在RAM中编制和布局。这是“将其推动到软件”模式,我看到一遍又一遍地失败,而它可能为像谷歌这样的组织工作,这对于试图做ML的普通组织并不实用。因此,为什么谷歌不销售TPU,他们销售可以在云中使用它们的服务。没有人想要锁定你的自定义奇怪的服务,这就是为什么他们在云空间中失去AWS和Azure的原因。

我可以找到的最好的文档在这里,以及此演示文稿从V2到V3的更改。似乎它们具有非常大的2D阵列,128x128(在v1中的256x256中减少了V2)。和VLIW指令(至少只有322位),将所有复杂性推入编译器中。

TPUv4文档出来,它们看起来还不错。希望我能买一送一个。它们也使用ML为TPUv5进行布局。

与NVIDIA类似的缺点,但在软件方面的投资少得多。我不知道任何用这些用来训练的人。来自抽搐聊天:“rocm =请使用内核版本5.4.1.4.12.44.1,只有5.4.1.4.12.44.1”在实践中不可用。

Huawei ascend910在Mlperf 0.7的列表中制作,所以我在这里包括在这里,即使我不能购买筹码或似乎使用它们。它们似乎使用了16x16x16矩阵单元,而不是一个糟糕的选择。但它只支持FP16,这是一个用于训练的软件麻烦。在此发现更多信息,似乎是苹果神经发动机的样子。

我们的目标是击败NVIDIA并在培训快10倍的培训芯片(因为我们有缓存带宽来喂养我们的张量核心),并且减少10倍(因为我们没有过充电,并且可以省略所有GPU硅)。相同的D2C商业模式,只有目的的内置硬件,用于ML培训,而不是将其俯冲到游戏设备。

我一直在研究RISC-V的扩展,其中包括32x32x32矩阵乘以单位,以及其他一些宽边矢量样式指令。我只支持TF32数据类型(19位),因此在没有梯度缩放的盒子中训练会很好(这是一个真正大量的软件复杂性,以便将较大的浮点范围重新进入FP16)。虽然有了较小的数据类型的培训,但它非常讨厌!

似乎一遍又一遍地被遗忘的课程是VLIW不起作用(Itanium),并且花哨的多核不起作用(Cell SPE)。你必须让芯片人喜欢在硬件上进行编程!否则,您将它推向软件,它永远不会发生。 Itanium编译器怎么样?

我最近一直在学习电脑架构,我一天写了一个RISC-V核心。我认为这个想法是一个单一的RISC-V核心,具有非常宽的解码路径,并且良好的顺序支持。 M1有一个630个元素重新排序缓冲区,我们甚至不会需要这么多来保持我们的Macs喂养。虽然针对这种架构的论证是它使用权力,但这只是大量多核设计中的问题!如果您的基本指令是32x32x32 Matmul(65k拖鞋),则将通过FMACS使用的功率赋予。我不认为分支预测因子需要是良好的,ml代码是直接的循环,并且每次运行都是相同的。

非NVIDIA培训解决方案的最大问题之一是可怕的软件支持。这不是因为它很难写,这是因为它很难用这些公司提出的奇怪建筑筹码的表演。由于此芯片是单核,广泛的解码路径超标,写入代码应该很容易,甚至支持所有具有体现性能的Pytorch。

樱桃一步:我的第一步是写入开源Verilog实现可以在S7T-VG6,Xilinx Alveo或FK33中运行的此核心。根据我的初始基准,假设每周期1指令和1个GHz时钟速度,这会令人舒服地优于3090.这个FPGA卡的费用为7500美元,因此使用这是逗号的逗号,它将被爱好者采用。 (对于这个阶段而言,只要开源代码和炒作建设)

樱桃二:我的第二步是做这个芯片的10K单位的磁带作为ASIC(我听到合理的12nm过程节点的500万美元)。 1核心,20MB SRAM,PCIe Gen3 X16,无板载大RAM(使用主机),75W TDP。由于不需要支持的汽车,我认为这张卡的观众将比逗号EON更广泛,更类似于Oculus DK1。在每次1,000美元销售10K卡后,该公司将是有利可图的! (为此阶段,验证和磁带筹集5000万美元)

樱桃三:我的第三步是在现代(< = 5nm)的过程节点上建立一个严肃的这个芯片版本,也许是磁带50米。 16核心(带NCCL样式原语),320MB SRAM(每核,隔离20MB,隔离),PCIe Gen4 X16,现代GPU式DDR接口,300W TDP。以2000美元的价格出售此卡,我怀疑迅速云需求来自正确的方向,这是底部的!其中一个卡应该优于一个高达199万台机器的DGX A100。这是100倍的价格改进。此时,我们将赢得AI芯片市场,即使是针对NVIDIA的下一代。 (在此阶段为500米筹集1000万美元,严重验证和磁带)

此时,我们将公司投入至少1亿美元,除了NVIDIA,他们将在高度经济上有动力继续销售卡D2C(类似于Facebook Oculus销售)。应该是一款轻松的销售,有10倍的收入多倍,假设我们销售了50k樱桃三张牌。该公司已实现三种目的:

为ML的NVIDIA制作了竞争对手,强迫他们停止收取10倍的保费。

我认为这是3年的可行。第一张牌(FPGA)只有TinyGrad支持,但它足以对所有现代ML型号,效率,YOLO和变压器的基准测试培训。开源社区将通过第二张卡出来的时间来帮助推动大型的Pytorch支持,从为Tinygrad贡献多少,以及人们如何在逗号EON时代向OpenPilot添加所有汽车支持。

在完成基准测试并确认我可以从FPGA卡获得3090级绩效之后,我将考虑纳入这家公司并提高资金。只允许与世界上总体价值创造一致的投资者投资。查看有关业务计划的更多信息。

如果您有兴趣在樱桃计算机工作,请开始为Tinygrad提供贡献。它仍然需要全力支持风险架构(RISC-V矢量扩展)和更好的基准。这应该适合某人新的,请参阅更新的Todo部分。我正在努力在Twitchcore中为核心本身工作,但在TinyGrad Side是一个更好的开始。