Facebook向团体管理员提供新的工具套件,包括识别“有争议或不健康的对话”的AI-Powered冲突警报

Facebook正在推出一套新工具,以帮助小组管理员抓住他们的社区。有些只是提供更清晰的帖子和成员概述,而其他人则旨在帮助管理员解决问题 - 包括Facebook所说的AI动力功能,可以识别评论中的“有争议或不健康或不健康的对话”。

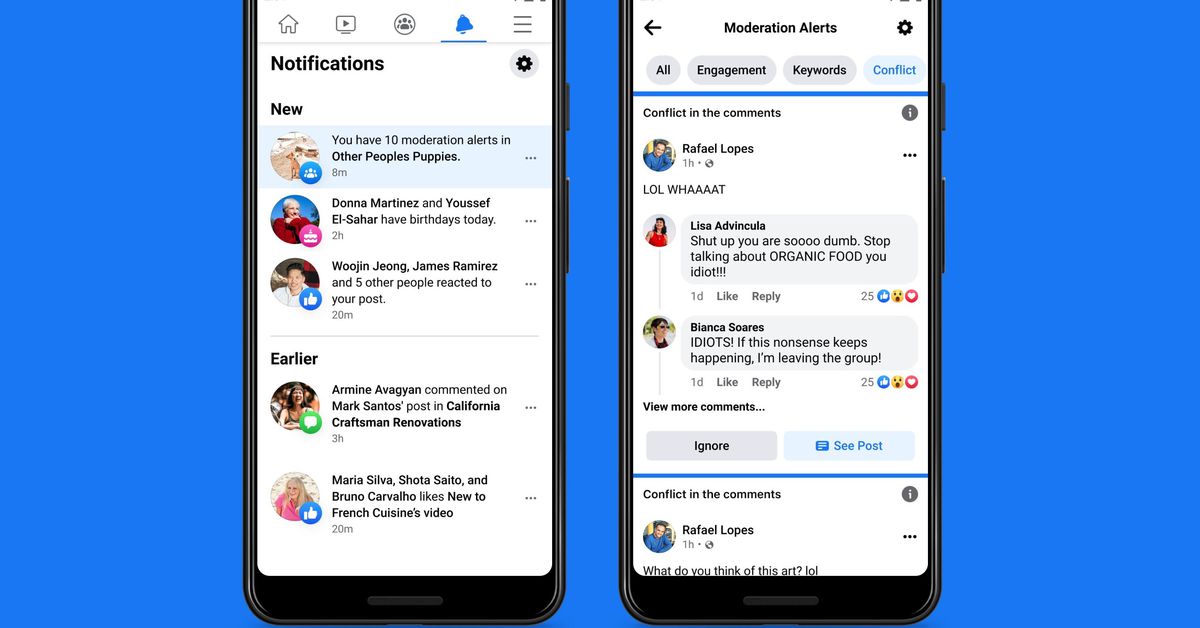

此工具被称为冲突警报,Facebook表示,它只是在现在进行测试,因此可用性尚不清楚。它类似于现有的关键字警报功能,它让Admins为评论者使用某些单词和短语时创建自定义警报,但使用机器学习模型来尝试找到更微妙的麻烦。一旦管理员被警告,他们可以通过删除评论,从组启动用户来获取行动,从而限制个人可以评论的频率,或者如何在某些帖子上进行评论的频率。

迄今为止,该功能究竟是如何检测到“有争议的或不健康或不健康的对话”并不清楚,并且在达到评论时,Facebook提供了很少的额外细节。一位发言人只说该公司将使用机器学习模型来查看“多个信号,例如回复时间和评论卷,以确定用户之间的参与是否有或可能导致负面交互。”

据推测,冲突警报使用类似于这些Facebook的AI系统部署到网站上的滥用滥用语音。这些模型远非100%可靠,并且通常被幽默,讽刺和俚语等简单的东西所迷惑。然而,他们应该能够接受争论发生的更明显的线索 - 就像有人称之为“白痴!”如上样的样本截图。

今天推出的管理员的其他新工具包括一个新的管理员主页,它将作为仪表板运行,概述“帖子,成员和报告的评论”以及访问新成员摘要,这些总摘要将编译“每个组成员的活动”小组,例如他们发布和评论的次数,或者当他们在本集团中删除或被静静时删除帖子。“

还有一个新的管理员协助功能,可用于自动化评论审核。这将让Admins限制谁被允许发表评论(让他们最近加入用户)以及禁止某些链接来遏制垃圾邮件和不需要的促销。冲突警报功能将成为Admin Assist的一部分。

您可以阅读更多关于Facebook博客帖子公告中所有这些功能的信息。