基于CPU的算法将深度神经网络培训高达15倍,而不是顶部GPU

赖斯大学计算机科学家展示了在商品处理器上运行的人工智能(AI)软件,并在基于图形处理器的平台上速度快15次培训深度的神经网络。 "培训成本是AI,&#34的实际瓶颈; Anshumali Shrivastava是米饭'布朗工程学院的计算机科学助理教授。 "公司每周花费数百万美元才能训练和微调他们的AI工作负载。"

ShrivaStava和ShivaStava和来自Rice和Intel的合作者将呈现研究,该研究在机器学习系统会议MLSYS上解决了瓶颈8月8日。

深度(DNN)是一种强大的形式,可以在一些任务中优于人类。 DNN培训通常是一系列操作,是图形处理单元(GPU)的理想工作负载,比通用中央处理单元(CPU)的成本大约需要三倍。

"整个行业都是关于一种改进 - 更快的矩阵乘法," Shrivastava说。 "每个人都在看专业的硬件和架构来推送矩阵乘法。人们现在甚至谈论有专门的硬件 - 软件堆栈,用于特定的深度学习。而不是占据昂贵的算法,并在它上抛出整个系统优化世界,而不是''让' s重新审视算法。'"

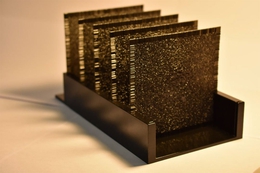

ShrivaStava' S实验室在2019年做了,重用DNN培训作为可以用哈希表解决的搜索问题。他们的"子线性深度学习引擎" (幻灯片)专门设计用于在商品CPU上运行,并且当在MLSYS 2020揭开时,英特尔的ShivaStava和合作者显示它可能会占GPU的训练。

本周在MLSYS 2021的情况下,他们在MLSYS 2021探索了幻灯片和#39; S性能是否可以改善现代CPU中的矢量化和记忆优化加速器。

"基于哈希表的加速已经胜过GPU,但CPU也在不断发展,"该研究生Shabnam Daghaghi学习学习,一名稻米研究生。 "我们利用这些创新进一步吸引幻灯片,表明如果您在矩阵乘法中竞争,您可以利用现代CPU和火车AI模型的电源,比最佳专业硬件快4到15倍替代品。"

研究共同作者Nicholas Meisburger,米本科,说" CPU仍然是计算中最普遍的硬件。 使它们对AI工作负载更有吸引力的好处无法低估。" Citation:CPU算法培训深度神经网络速度快于Top GPU培训师(2021,4月7日)从HTTPS://techxplore.com/news/2021-04-Rice-Intel-Optimize-ai-检索到的GPU培训师(2021,4月7日) Commodity.html. 本文件受版权保护。 除了私人学习或研究目的的任何公平交易外,没有书面许可,没有任何部分。 内容仅供参考。