为什么机器学习与因果关系挣扎

本文是我们对AI研究论文评论的一部分,这是一系列探索人工智能最新发现的一系列帖子。

当您查看以下短视频序列时,您可以对不同元素之间的因果关系进行推断。例如,你可以看到蝙蝠和棒球运动员的手臂齐声移动,但你也知道这是玩家的手臂,导致蝙蝠的运动,而不是相反的方式。您也不需要被告知蝙蝠导致突然变化在球的方向上。

同样,您可以考虑反事实,例如如果球飞得更高并且没有击中蝙蝠会发生什么。

这种推断直观地对我们的人来说。我们在一个很小的年龄地学习它们,而不被任何人明确指导,只是通过观察世界。但是对于机器学习算法,这已经设法以Go和Chess等复杂任务更优于人类,因此因果关系仍然是一个挑战。机器学习算法,尤其是深神经网络,尤其擅长在大量数据中脱颖而出。它们可以实时转录音频,每秒标记数千个图像和视频帧,并检查X射线和MRI扫描以获取癌症模式。但他们努力使我们刚刚在上面棒球视频中看到的简单因果推断。

在一个标题为“因果代表学习”的文件中,Max Planck智能系统智能系统研究所(MILA)和谷歌研究所的Max Planck智能系统研究所和谷歌研究,讨论了机器学习模型中缺乏因果表现产生的挑战提供创建可以学习因果表现的人工智能系统的方向。

这是旨在探索和解决机器学习缺乏因果关系的几项努力之一,这可能是克服现场今天面临的一些主要挑战的关键。

为什么机器学习模型在狭窄的域和培训数据之外都会失败?

“机器学习往往无视动物使用的信息:世界上的干预措施,域名转移,时间结构 - 逐渐,我们认为这些因素是滋扰并试图将它们工程师们送走,”写下因果代表学习纸的作者。 “按照这一点,大多数当前机器学习成功的成功归结为适当收集的独立收集的大规模模式识别,并相同分布(即)数据。”

I.I.D.是一个经常用于机器学习的术语。它假设问题空间中的随机观察不依赖于彼此并且具有恒定的发生概率。最简单的例子。正在翻转硬币或折腾模具。每个新的翻转或折腾的结果与先前的翻转或折腾的结果无关,每个结果的概率保持不变。

当涉及计算机视觉等更复杂的领域时,机器学习工程师试图将问题变成I.I.D.域通过在非常大的例子上培训模型。假设是,通过足够的示例,机器学习模型将能够将问题的一般分布编码为其参数。但在现实世界中,由于在训练数据中无法考虑和控制的因素,分布通常会发生变化。例如,在数百万图像上培训的卷积神经网络可以在新照明条件下或从略微不同的角度或对新的背景下看到物体时失败。

解决这些问题的努力主要包括更多示例的培训机器学习模型。但随着环境在复杂性的增加,通过添加更多培训例子,不可能覆盖整个分布。在域名必须与世界互动,例如机器人和自动驾驶汽车等域中尤其如此。缺乏因果理解使得难以做出预测和处理新颖的情况。这就是为什么你看到自动驾驶汽车的错误,即使在数百万英里训练过的时候也能产生奇怪和危险的错误。

“概括在I.I.D之外。设置需要学习不仅仅是变量之间的统计关联,而是一个潜在的因果模型,“AI研究人员写道。

因果模型还允许人类重新培养以前获得了对新域的知识。例如,当您学习魔兽等实时策略游戏时,您可以快速将您的知识应用于其他类似的游戏星际争霸和帝国年龄。然而,在机器学习算法中传输学习仅限于非常肤浅的用途,例如FineTuning图像分类器以检测新类型的对象。在更复杂的任务中,如学习视频游戏,机器学习模型需要大量的培训(数千年的戏剧),并对环境的微小变化进行应对良好(例如,在新地图上或略有变化或略有变化到规则)。

“在学习因果模型时,因此应该需要更少的例子来适应大多数知识,即模块,可以在没有进一步培训的情况下重复使用,”因果机学习纸写的作者写道。

所以,为什么我有.D。尽管其已知的缺点,但仍然是机器学习的主导形式?纯粹的观察方法是可扩展的。您可以通过添加更多培训数据来继续实现增量增益,并且您可以通过添加更多计算电源来加快培训过程。事实上,深度学习最近成功的关键因素之一是更多数据和更强大的处理器的可用性。

I.I.D.-基于模型也很容易评估:拍摄一个大型数据集,将其分成训练和测试集,调整培训数据的模型,并通过测量测试集预测的准确性来验证其性能。继续培训,直到您达到您所需的准确性。已经有许多公共数据集提供了这样的基准,例如想象成,CiFar-10和Mnist。还有特定于特定的数据集,例如Covid-19诊断和威斯康辛乳腺癌诊断数据集的Covidx数据集。在所有情况下,挑战是相同的:开发一种机器学习模型,可以基于统计规则预测结果。

但随着AI研究人员在纸质中观察到的,准确的预测通常不足以告知决策。例如,在Coronavirus大流行期间,许多机器学习系统开始失败,因为他们已经接受了统计规则而不是因果关系训练。随着生命模式改变,模型的准确性下降。

当干预措施改变问题的统计分布时,因果模型仍然坚固。例如,当您第一次看到一个对象时,您的思想将从其外观潜意识地进行照明。这就是为什么通常,在新的照明条件下看到它时,您可以识别该对象。

因果模型也允许我们回应我们之前没有看到的情况并考虑反事实。我们不需要驾驶悬崖上的汽车了解会发生什么。反事实在减少培训示例的数量方面发挥着重要作用,例如机器学习模型需要。

因果关系也可能对处理对抗性攻击至关重要,微妙的操纵,强迫机器学习系统以意想不到的方式失败。 “这些袭击显然构成了I.I.D的违规行为。假设是统计机器学习的基础,“论文写作,增加了对抗性漏洞是人类智能和机器学习算法鲁棒机制差异的证明。研究人员还表明,因果关系可能是对抗对抗攻击的可能性。

在广泛的意义上,因果关系可以解决机器学习的缺乏概括。研究人员写道,“这是公平的大多数当前的实践(解决I.I.D.基准问题)和大多数理论结果(关于I.I.D.设置的概念),”研究人员写道“

在纸质中,AI研究人员带来了几种概念和原则,这可能对创造因果机学习模型至关重要。

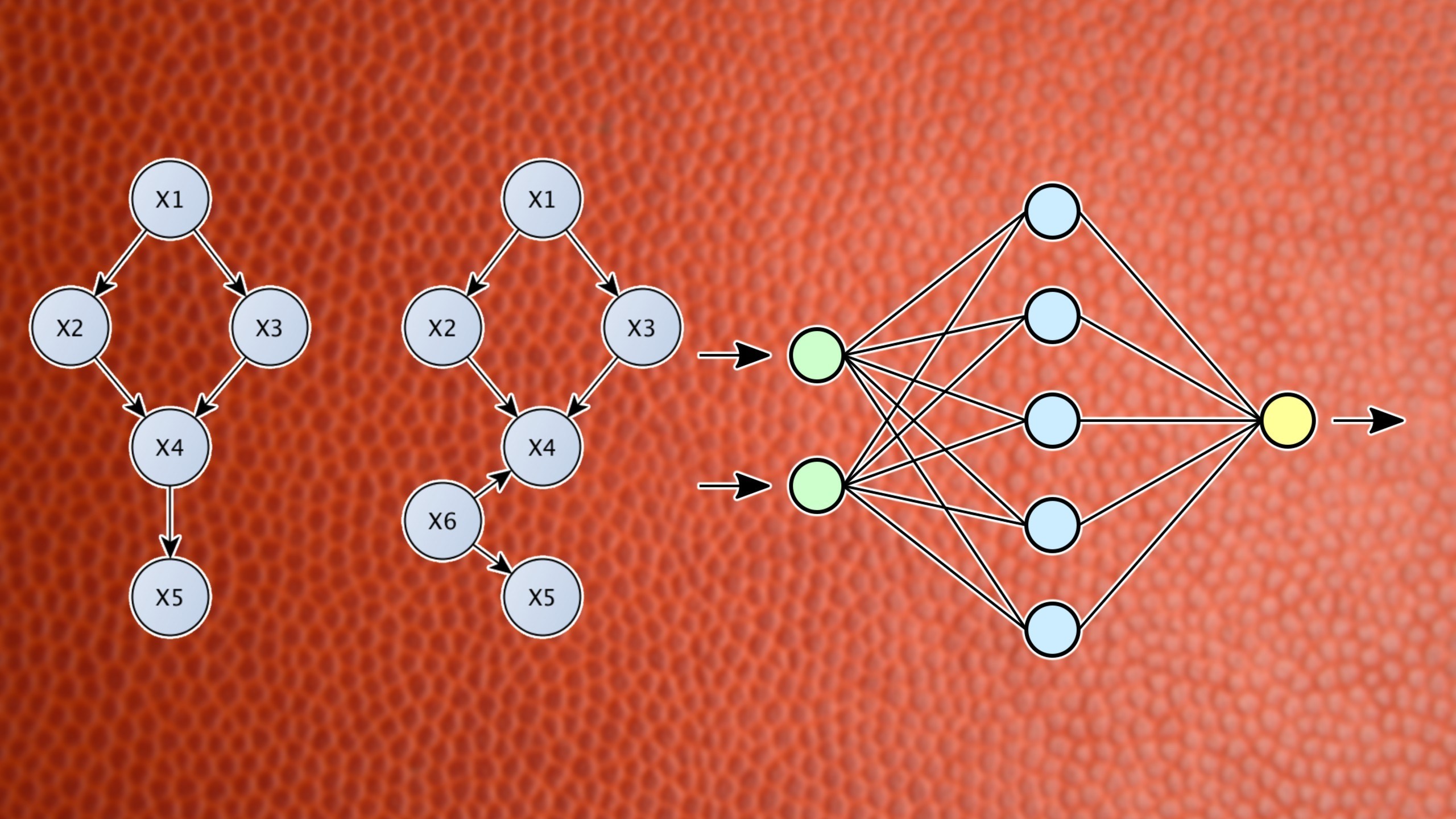

其中两个概念包括“结构因果模型”和“独立因果机制”。通常,原则状态,而不是寻找表面统计相关性,AI系统应该能够识别因果变量并将其对环境的影响分开。

这是使您能够检测不同对象的机制,无论视角,背景,照明和其他噪声如何。解开这些因果变量将使AI系统对不可预测的变化和干预措施更加强大。因此,因果AI模型不需要巨大的训练数据集。

“一旦通过外部人类知识或学习过程提供了因果模式,因果推理允许结论干预措施,反事实和潜在结果”,“因果机学习纸张写作的作者”。

作者还探讨了这些概念如何应用于机器学习的不同分支,包括加强学习,这对智能代理依赖于探索环境和通过试验发现解决方案的问题至关重要。由于允许他们从培训开始而不是随机和非理性行动,可以帮助培训加强学习的培训更有效。

研究人员为AI系统提供了联合机器学习机制和结构因果模型的理念:“结合结构因果建模和表示学习,我们应该努力将SCM嵌入到更大的机器学习模型中,其输入和输出可能是高维和非结构化的,但其内部工作至少部分由SCM(这可以用神经网络参数化)。结果可以是模块化架构,其中不同的模块可以单独微调并重新饰有新任务。“

这些概念使我们更接近人类思维使用的模块化方法(至少据我们所知)来链接和重用跨大脑区域和地区的知识和技能。

然而,值得注意的是,论文中提出的想法是在概念层面。随着作者承认的,实施这些概念面临着几种挑战:“(a)在许多情况下,我们需要从可用的低级输入功能中推断出抽象的因果变量; (b)没有达成共识的数据,揭示了因果关系; (c)培训和测试集的通常实验协议可能不足以推断和评估现有数据集的因果关系,并且我们可能需要创建新的基准,例如访问环境信息和干预措施; (d)即使在有限的情况下,我们也会理解,我们经常缺乏可扩展且数字的声音算法。“

但有趣的是,研究人员从该领域所做的大部分并行工作中汲取灵感。本文包含对朱迪亚珍珠的工作的参考,这是一个为他在因果推断工作而闻名的图灵屡获殊荣的科学家。珍珠是一种纯粹深入学习方法的声音批评。与此同时,Yoshua Bengio是本文的共同作者之一和另一个图灵奖获得者,是深度学习的先驱之一。

本文还包含几种与Gary Marcus提出的混合AI模型重叠的想法,这与神经网络的模式识别能力相结合的符号系统的推理能力。但是,本文没有对混合系统进行任何直接引用。

本文还符合System 2深度学习,这是一个概念首次由Bengio在Neurips 2019 Ai会议上进行谈话中提出的概念。系统2背后的想法深入学习是创建一种类型的神经网络架构,可以学习来自数据的更高表示。更高的表示对因果关系,推理和转移学习至关重要。

虽然目前尚不清楚哪种拟议方法中的哪种方法有助于解决机器学习的因果问题,但思想来自不同 - 往往思考的思想的事实是保证产生有趣的结果。

“在它的核心,I.I.D.作者写道,模式识别是一种数学抽象,而且因果关系可能对大多数形式的动画学习是必不可少的。“ “到目前为止,机器学习忽略了完全一体化因果关系,本文认为它确实可以从整合因果概念中受益。”