PDF自动文本摘要有何困难? 更快的R-CNN和PEGASUS

如今,越来越多的文档和包含的信息必须由企业进行处理才能使用隐藏的内容。这可以通过耗时的手动文本摘要来完成,也可以通过使用自动化解决方案来完成。自动文本摘要可帮助人们有效地处理不断增长的信息量。

牛津英语词典将自动文本摘要定义为“通过计算机程序创建文本的简化版本。此过程的结果仍然包含原始文本中最重要的部分。” [1]

总结有用的一个很好的例子是公司的年度报告。这些文件包含许多对投资者至关重要的事实,因为它们包含了有关许多因素的信息,例如可持续性或环境政策,这些信息可以帮助投资者做出决定。但是,年度报告通常是很长的文档,有数百页,这使它们的分析成为一个耗时的过程,可以通过自动工作流程来简化。

我们将过程分为三个主要部分。对于这些步骤中的每一个,我们都将在本文的以下各节中进行更详细的介绍。随意跳入细节,或者让我们先引导您完成每个步骤的主要结果。

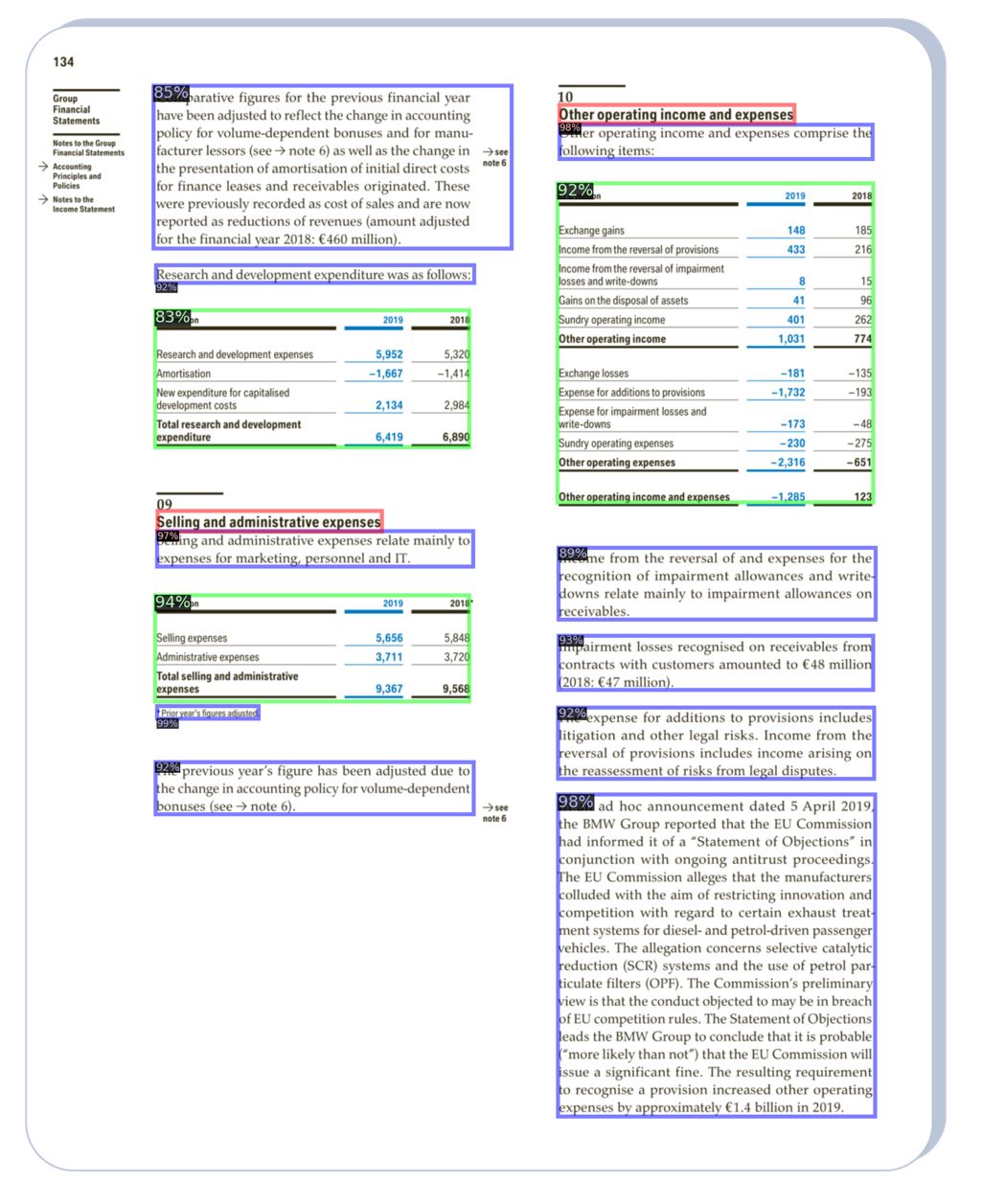

第一步,我们需要选择文档中必须关注的那些部分。虽然我们可以从图像,图形和标题中获得许多已经汇总的信息,但文本是最完整的信息源。将文档拆分为不同组件的一种可能方法是使用计算机视觉方法。用于多类对象检测的模型可以自动区分年度报告中的不同元素。所有内容都可以分为五类:标题,文本,表格,列表和图形。汇总过程的以下步骤仅使用找到的类别文本位置。

下一步是将文档的选定边界框转换为文本。这部分可以定义为光学字符识别(OCR)问题,可以使用现有工具解决。

最后一步是所选内容的汇总。最近被证明是功能强大的模型的所谓变形金刚开始发挥作用。我们使用了专门为自动摘要设计的量身定制的BERT模型PEGASUS。结果向我们展示了该段落的摘要版本,在第一步中我们从报告中检测到了该摘要并从中提取了该段落。原来的910个字符的长度减少为193个字符,从而节省了将近80%的时间。尽管如此,仍包含理解该段的所有相关信息。

参加2021年3月3日GMT + 1下午5:00至6:00下午的Meetup演讲。

对象检测是一项任务,其中在图像中识别出已知类别的对象,并提供有关其位置的信息。 Faster R-CNN是用于此任务的非常著名的体系结构。该体系结构为每个对象提供两个输出:一个类标签和一个边界框。它由两个模块组成:一个用于提出区域的深层全卷积网络和一个用于检测这些区域中对象的快速R-CNN。

起作用的方式是将输入图像馈送到提供该图像特征图的卷积网络。然后,一个分离的网络(区域提议网络)获取该特征图并预测对象的可能区域(区域提议)。这些区域提议被馈送到ROI合并层,从而将它们重塑为预定义的大小。最后,来自合并层的输出矢量用于对建议的区域进行分类并完善边界框。

最近,Mask R-CNN(它是Faster R-CNN的扩展)增加了第三个输出,该输出允许具有对象的蒙版。这样就得到了对象的分类,边界框和遮罩。遮罩预测与预测类和边界框并行进行[2]。

目标是仅选择报告的相关部分,在本例中为文本段落。其他已经包括摘要的部分(例如标题或表格)均不相关。因此,我们需要的第一件事是带有不同文档元素的带注释的数据集。 PubLayNet是一个数据集,在超过360 k页的科学论文上带有文本,图形,标题,列表和表格的注释[3]。通过微调在PubLayNet中训练的Mask R-CNN模型,我们可以得到一个模型,该模型使我们能够检测文档中与文本相对应的那些部分。我们使用的模型可在Detectron2平台中找到,该平台是Facebook AI Research的一个平台,可以快速测试最新算法[4]。在图中,我们可以看到边界框和分类以不同的颜色显示给每个类,这是没有任何微调的结果。对于我们的问题,我们对文本的掩码不感兴趣,仅对用蓝色突出显示的边界框不感兴趣。

免费注册,然后尝试使用您自己的文档进行页面细分API。注册以访问我们的API文档。使用我们的文档标签工具,您可以创建数据集并在自己的文档上微调PubLayNet模型。

找到我们感兴趣的图像部分后,下一步是使用光学字符识别(OCR)从图像中提取文本。 OCR可以通过计算机视觉方法来完成,该方法可以包括字符的检测,分割和识别,但是最近的方法包括CNN和递归神经网络的组合。

后处理–例如,可以通过与更常见的单词序列进行比较来纠正错误。

可以使用几种OCR工具。我们找到了选择每个项目OCR的最佳方法。因此,在Konfuzio,我们集成了不同的OCR引擎。在此视频中,您可以看到我们的API如何检测手写。

现在通常使用Transformer模型进行汇总。变压器是2017年推出的一种神经网络架构。它们最初是为机器翻译而设计的,但如今已用于几乎所有现代NLP应用程序,例如:实体识别,自然语言推理,问题回答和摘要。与之前的先进模型LSTM相继处理数据相比,变压器能够并行处理所有输入数据。这种并行化功能使它们更易于按指数级增长的计算和数据规模进行扩展。

Transformer体系结构中引入的主要新颖概念是“多头注意”的使用。在Transformer中,输入序列中的每个元素都分为三个向量:Q,K和V。注意力作为这些向量的加权总和进行计算,其中权重既是学习的,又是上下文相关的。换句话说,输入模型的数据决定了模型应将注意力集中在哪里。多头注意力意味着我们将每个向量分成多个“头”,并并行计算每个头的注意力。因此,在将结果合并到输出之前,我们一次并行执行多个注意力计算。 [5]

最常用的Transformer变体称为BERT。 BERT只使用原始Transformer中的编码器,但架构变化很小。 BERT的主要新颖之处在于,它被训练为针对大量未标记文本的“掩蔽语言模型”。蒙版语言模型的任务是“填充给定句子的空白”,即给定句子以[MASK]标记替换一些单词,然后尝试预测实际的单词是什么。事实证明,此任务对模型讲了很多有关自然语言的知识,以至于现在普遍采用预先训练的BERT模型,然后对其进行微调。在尝试用于NLP的神经网络时,这通常是一个很好的起点,并且现在大多数NLP研究都集中在如何通过调整体系结构或发明新的预训练目标来改进Transformer模型及其变体。

PEGASUS是设计用于自动汇总的模型。该架构与原始的Transformer(带有解码器)相似,但同时对两个任务进行了预训练。第一项任务是BERT引入的屏蔽语言建模任务。第二项任务涉及预测输入中被掩盖的整个句子。首先要对PEGASUS进行预培训,使其包含大量文本,包括15亿篇新闻文章,然后在目标数据集上进行微调。它在十二个常用的摘要数据集中实现了最先进的性能。 [6]。

更快的R-CNN OCR python文本摘要

统一的培训数据:理论和实践免费测试在您了解了说明1的基础知识和说明2的各个部分之后... 阅读故事 AI扫描仪软件可在几秒钟内捕获汽车行业,保险公司和当局的所有数据,许多研讨会都从...获取信息。 阅读故事 如何使用模板优化项目免费测试它在您第一次学习基础知识之后... 阅读故事 我在此确认已阅读并理解了数据保护条件。 通过发送数据,我同意这一点。

我在此确认已阅读并理解了数据保护条件。 通过发送数据,我同意这一点。