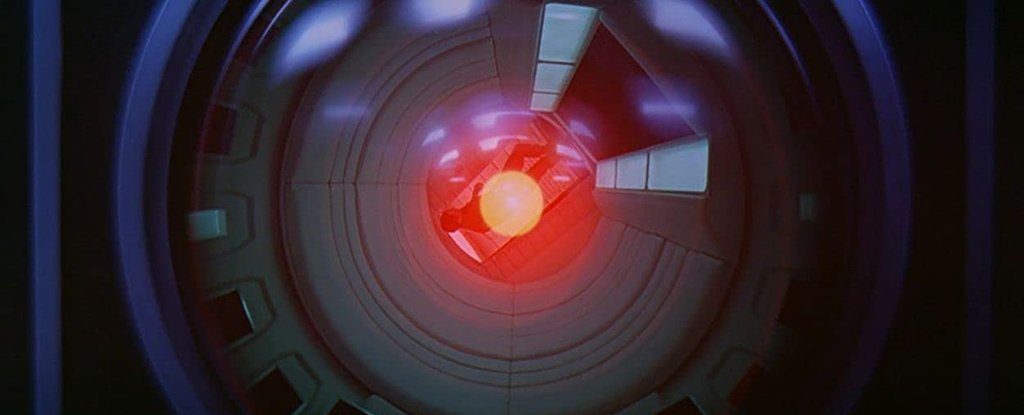

计算表明不可能控制超智能AI

人工智能推翻人类的想法已经讨论了几十年了,科学家们刚刚就我们是否能够控制高级计算机超级智能做出了判断。答案?几乎肯定不是。

要注意的是,要控制一个超出人类理解能力的超级智能,就需要对这种超级智能进行模拟,我们可以对其进行分析。但是,如果我们无法理解它,就不可能创建这样的模拟。

诸如此类的规则不会对人类造成伤害新论文的作者建议,如果我们不了解人工智能将要提出的那种情况,就无法设置。一旦计算机系统的工作水平超出了程序员的范围,我们将无法再设置限制。

"超级智能提出的问题与通常以“机器人伦理”,“#34;写研究人员。

"因为超级智能是多方面的,因此潜在地有能力动员多种资源来实现人类可能无法理解的目标,更不用说可控了。

团队的部分推理来自于艾伦·图灵(Alan Turing)在1936年提出的暂停问题。问题的中心在于知道计算机程序是否会得出结论并回答(因此会暂停),或者只是循环循环进行永久尝试找一个。

正如Turing通过一些聪明的数学证明的那样,虽然我们可以知道对于某些特定程序,但从逻辑上讲,不可能找到一种方法让我们知道每个可能编写的程序。这使我们回到了AI领域,在超级智能状态下,它可以一次将所有可能的计算机程序保存在其内存中。

例如,为阻止AI伤害人类并破坏世界而编写的任何程序都可能会得出结论(或停止)-从数学上讲,我们绝对无法确定哪种方法,这意味着它确实是对的。无法遏制。

"实际上,这使包含算法无法使用,"德国马克斯-普朗克人类发展研究所的计算机科学家Iyad Rahwan说。

研究人员说,向AI讲道德并告诉其不要破坏世界的另一种方法是限制超级智能的能力,这是算法绝对不能确定的。例如,它可以与部分互联网或某些网络隔离。

这项新研究也拒绝了这个想法,暗示它将限制人工智能的应用范围。论点是,如果我们不打算使用人工智能来解决人类无法解决的问题,那为什么还要创造它呢? ?

如果我们要推进人工智能,我们甚至可能不知道何时会出现我们无法控制的超级智能,这就是它的不可理解性。这意味着我们需要开始对我们前进的方向提出一些严肃的问题。

"控制世界的超级智能机器听起来像科幻小说," Max-Planck人类发展研究所的计算机科学家Manuel Cebrian说。 "但是已经有机器能够独立执行某些重要任务,而程序员却没有完全了解他们的学习方式。

"因此,出现了一个问题,在某些时候这是否可能变得不可控制并且对人类构成危险。