OpenAI API

我们正在发布一个API,用于访问OpenAI开发的新AI模型。与大多数为一种用例设计的人工智能系统不同,API今天提供了一个通用的“文本输入,文本输出”界面,允许用户在几乎任何英语任务上尝试它。您现在可以申请访问权限,以便将API集成到您的产品中,开发全新的应用程序,或者帮助我们了解这项技术的优势和局限性。

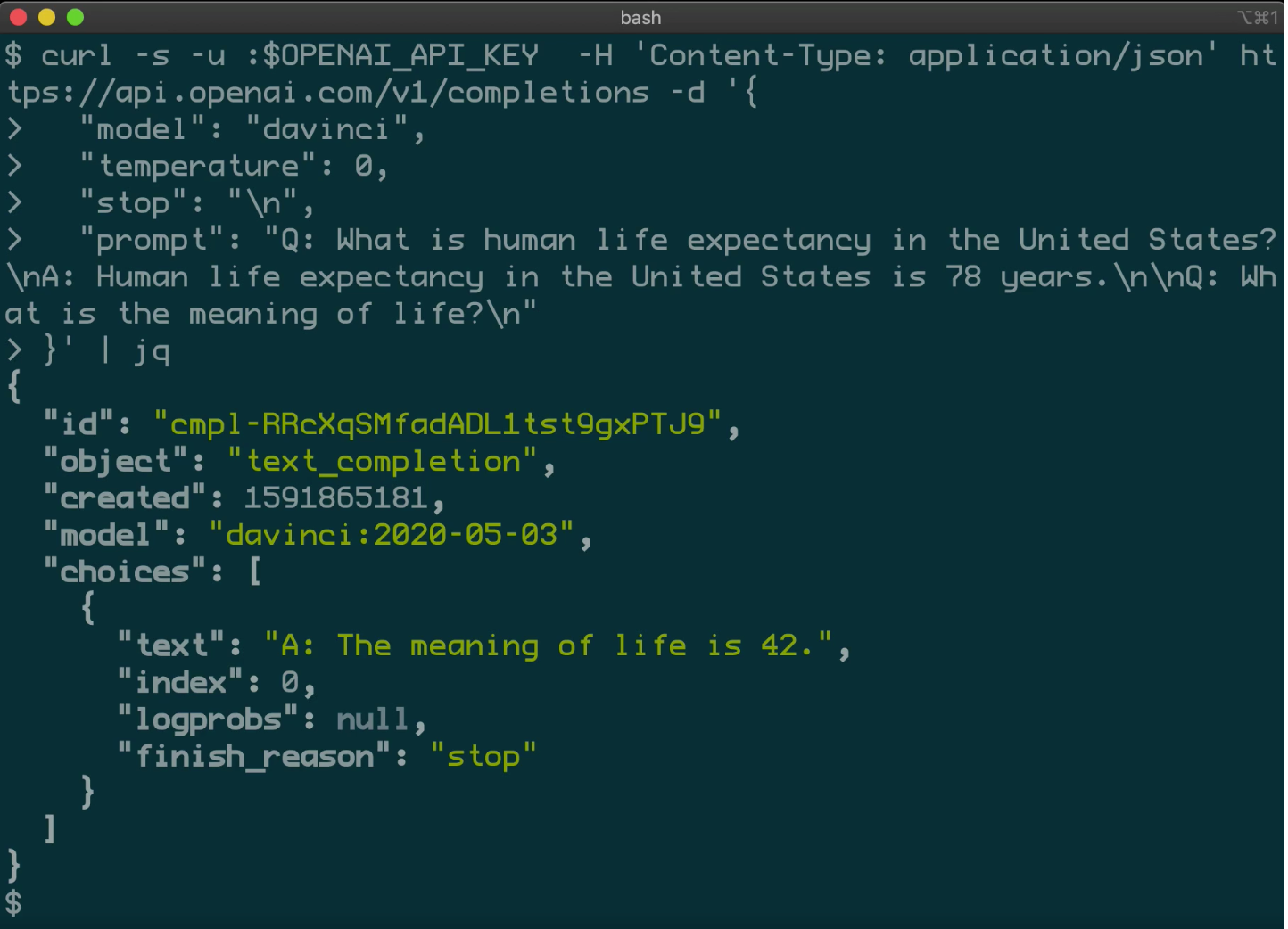

给定任何文本提示,API将返回文本完成,尝试匹配您给出的模式。你只需向它展示几个你希望它做什么的例子,就可以对它进行编程;它的成功程度通常取决于任务的复杂程度。API还允许您通过对您提供的示例的数据集(无论大小)进行培训,或者从用户或标签员提供的人工反馈中学习,来磨练特定任务的性能。

我们设计的API既简单易用,又足够灵活,使机器学习团队的工作效率更高。事实上,我们的许多团队现在都在使用API,这样他们就可以专注于机器学习研究,而不是分布式系统问题。如今,API使用GPT-3系列中的权重运行模型,速度和吞吐量都有许多改进。机器学习的发展非常迅速,我们正在不断升级我们的技术,以便我们的用户保持最新。

这一领域的进展速度意味着人工智能经常出现令人惊讶的新应用,既有积极的,也有消极的。我们将针对明显有害的使用案例终止API访问,例如骚扰、垃圾邮件、激进化或占星术。但我们也知道,我们无法预测这项技术可能带来的所有后果,所以我们今天将以私人测试版而不是普遍提供的形式推出,构建工具来帮助用户更好地控制我们的API返回的内容,并研究语言技术的安全相关方面(如分析、减轻和干预有害偏见)。我们将分享我们所学到的知识,以便我们的用户和更广泛的社区能够构建更多具有人类积极性的人工智能系统。

除了作为帮助我们支付追求使命成本的收入来源外,API还推动我们更加关注通用人工智能技术-推进技术,使其可用,并考虑其在现实世界中的影响。我们希望API将大大降低生产有益的AI驱动产品的门槛,从而产生今天很难想象的工具和服务。

对探索API感兴趣吗?加入Algolia、Quizlet和Reddit等公司以及米德尔伯里研究所(Midlebury Institute)等机构的研究人员参与我们的私人测试版。

归根结底,我们最关心的是确保人工通用智能造福每个人。我们认为开发商业产品是确保我们有足够资金取得成功的方法之一。

我们还认为,在世界上安全部署强大的人工智能系统将很难做到正确。在发布API时,我们正在与我们的合作伙伴密切合作,看看人工智能系统在现实世界中使用时会出现什么挑战。这将有助于指导我们的努力,以了解部署未来的人工智能系统将如何进行,以及我们需要做些什么来确保它们对每个人都是安全和有益的。

我们这样做的主要原因有三个。首先,将技术商业化有助于我们为正在进行的人工智能研究、安全和政策努力买单。

其次,API底层的许多模型都非常大,需要大量的专业知识来开发和部署,这使得它们的运行成本非常高。这使得除了较大的公司之外,任何人都很难从底层技术中受益。我们希望API将使功能强大的AI系统更容易为较小的企业和组织所访问。

第三,API模型使我们能够更容易地应对技术的滥用。由于我们的模型的下游用例很难预测,因此通过API发布它们并随着时间的推移扩大访问比发布开放源码模型更安全,因为在开源模型中,如果发现有有害的应用程序,访问将无法调整。

鉴于您之前所说的关于GPT-2的内容,OpenAI将具体对API的滥用做些什么?

我们将终止API的使用访问-对人们造成身体或精神伤害的情况,包括但不限于骚扰、故意欺骗、激进化、占星术或垃圾邮件;随着我们在实践中获得更多操作API的经验,我们预计将扩大和完善这些类别。

我们还在对API提供的模型的潜在滥用进行研究,包括通过我们的学术访问计划与第三方研究人员合作。

到目前为止,我们一直在与我们单独审查的用户进行私人测试版,这进一步降低了误用的可能性,同时我们更好地理解了API的含义和局限性。

OpenAI将如何减轻API提供的模型的有害偏见和其他负面影响?

减轻有害偏见等负面影响是一个极其重要的全行业难题。最终,我们的API模型确实显示出偏差(如GPT-3论文中所示),这些偏差有时会出现在生成的文本中。我们的API模型还可能以我们还没有想到的方式造成危害。以下是我们为解决这些问题而采取的步骤:

我们正在与用户一起制定使用指南,以帮助他们相互学习,并在实践中缓解这些问题。

我们正在与用户密切合作,深入了解他们的使用案例,并开发工具来标记和干预有害偏见的表现。

我们正在对有害的偏见和更广泛的公平和代表性问题进行研究,这将有助于为我们与用户的工作提供信息。

随着时间的推移,我们的目标是彻底了解API的潜在危害,并不断改进我们的工具和流程,以帮助将其降至最低。

我们将努力分享我们所学到的知识,这样别人才能受益。我们也希望看到其他AI开发人员也这样做,因为偏见是AI开发中的集体行动问题。