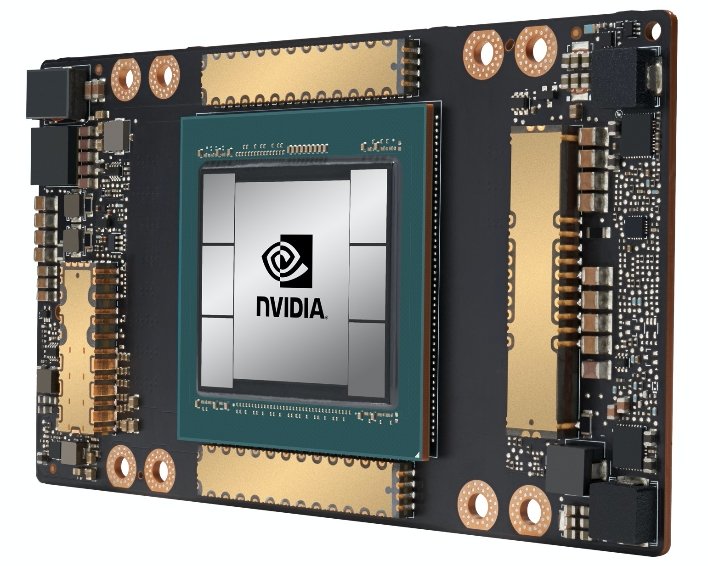

面向AI的NVIDIA安培A100图形处理器亮相,有史以来最大的7 nm芯片

在过去的两年里,我们一直听说NVIDIA的下一代安培,但该公司终于准备好谈论它的下一代GPU架构了。虽然您今天不会听到任何有关GeForce RTX 30系列消费级游戏显卡的信息,但NVIDIA正在讨论有关机器学习数据中心和HPC市场的安培的详细信息。简而言之,这个版本的安培是NVIDIA有史以来最大、最强大的图形处理器,该公司表示,它也是世界上最大的7 nm芯片。毫无疑问,它是巨大的。据NVIDIA报道,其基于安培的A100图形处理器已经全面生产并交付给客户,该公司声称A100代表着其历史上最大的一代图形处理器性能提升。鉴于规格,我们没有理由怀疑该公司。

A100拥有高达540亿个晶体管,这无疑使它成为世界上最大的基于7纳米技术的处理器。总共有6912个FP32 CUDA核心、432个张量核心和108个SMS。板载是40 GB的HBM2e内存,最大内存带宽为1.6TB/秒。FP32计算的TLFLOPS达到了惊人的19.5 TLFLOPS,相比之下,特斯拉V100的TFLOPS为16.4 TFLOPS。FP64计算的TFLOPS为9.7 TFLOPS,而特斯拉V100的TFLOPS为8.2 TFLOPS。此外,其张量芯采用FP32精度,可将人工智能性能提升20倍。在FP64性能方面,与其前身Volta相比,这些张量内核在高性能计算(High Performance Compute)应用方面也提供了2.5倍的性能提升。

其他一些安培专用功能包括多实例GPU(又名MIG),它允许将一个A100 GPU分割为最多七个独立实例。这样,就可以为多个离散的专用工作负载提供芯片的原始功率。安培还集成了第三代NVLink设计,可将多个GPU之间的互连性能提高一倍,从而提高可扩展性。

NVIDIA创始人兼首席执行官Jensen Huang表示:“NVIDIA A100图形处理器是20倍的人工智能性能飞跃,是端到端的机器学习加速器-从数据分析到培训再到推理,”NVIDIA创始人兼首席执行官简森·黄(Jensen Huang)说。";第一次可以在一个平台上加速纵向扩展和横向扩展工作负载。NVIDIA A100将同时提高吞吐量并降低数据中心的成本。“。

这些A100图形处理器也将进入NVIDIA的第三代DGX人工智能超级计算机,具有5千万亿次的人工智能性能。周二,当詹森从他的私人家庭烤箱中拿出一台新鲜出炉的钻机时,他给了我们一个很早的DGX A100的味道。当时,他宣称它是“世界上最大的显卡,但不幸的是,它的目标职责不是游戏。

DGX A100共有8个A100 GPU,以及320 GB内存(带宽为12.4 TB/秒)。该系统还配备了Mellanox HDR 200Gbps互连。如前所述,每个A100 GPU最多可以支持7个实例,这意味着如果板载8个GPU,DGX A100总共可以支持56个实例来攻击手头的工作负载。

然而,NVIDIA也在考虑不仅仅是DGX A100,并宣布开发DGX SuperPod,它结合了使用前述Mellanox互连连接的140个DGX A100系统的功能。加在一起,你将看到700千万亿次的人工智能计算能力,可以用于从医学研究到帮助分析冠状病毒的任何事情,就像我们在Folding@Home项目中看到的那样。

NVIDIA看起来在安培和A100上有了一个强劲的开端,但我们当然也期待着看到该公司为爱好者市场准备了什么。自从NVIDIA与GeForce RTX 20系列推出图灵架构以来,已经过去了18个多月,人们对GeForce RTX 30系列的期望值高得令人难以置信。